“Бизнес ПсихоЛогика” 2026: Кой плаща сметката, когато ИИ сгреши?

Какво в нашата Бизнес ПсихоЛогика се подрежда и какво се чупи с AI? Кой носи отговорността за грешките и какви са регулациите на отношенията човек-машина-потребители? Можем ли да знаем със сигурност какво, кога, как и защо е по-добре да делегираме на изкуствен интелект (ИИ) и кое трябва да се върши 100% ръчно от хората? Днес ще се потопим в ключова за бизнеса тема от сферата на AI психологията: чия е отговорността за данните, генерирани с ИИ, с които оперираме?

След 15 месеца на интензивно изследване и изграждане на рамки и процеси за коригиране на “кашите”, които масовото навлизане на ИИ създаде, моят извод е един: сигурността, надеждността и валидността не са просто маркетингови думи. Това са реални бизнес процеси, които малкият и микро бизнес у нас тенденциозно пренебрегват с илюзията, че са “твърде малки, за да бъдат значими”. AI демократизира човешките системи и процеси и позволява на хората да строят, създават и изграждат, което със сигурност създава нови пазарни възможности.

Тази свобода обаче върви ръка за ръка с отговорности. През 2026 г. влизат в сила регулации като Cyber Resilience Act (CRA), които ще променят правилата на играта за всички, предлагащи AI + API + Local Training. В момента рисковете са изцяло за сметка на крайния клиент, а отговорност за течове на данни и сензитивна информация на практика не се носи.

Отношенията “човек-машина” не са еднозначни и в повечето случаи ИИ ни хваща неподготвени: можем ли да му имаме доверие наистина? Кога той е по-добър от нас и кога трябва да разчитаме на себе си? Илюзия ли е, че знаем и умеем повече днес, когато уж имаме отговори на въпросите си, но ни липсва мъдрост, опит, ценности и идеи как да ги прилагаме на практика?

Готов ли е бизнесът ви за AI регулациите през 2026? Разберете защо ИИ е “черна кутия”, какви са рисковете от Cyber Resilience Act и как да запазите човешката логика в процесите си. Останете до края на тази статия, за да научите:

- Какво е AI Психология?

- Къде се къса веригата и кои са най-големите рискове при употреба на ИИ?

- Психологическата цена на „липсата на триене“

- Регулаторната рамка на Европейския Съюз за 2026: Краят на „Дивия запад“ за ИИ инструментите

- Защо тези регулации адресират реални рискове в бизнес логиката?

- Как ползваме при нас ИИ за вътрешни цели при изграждане на процеси?

- Изкуственият интелект е технология, а не решение

- Как се постига точност на резултатите с ИИ над 98%?

Какво е AI Психология?

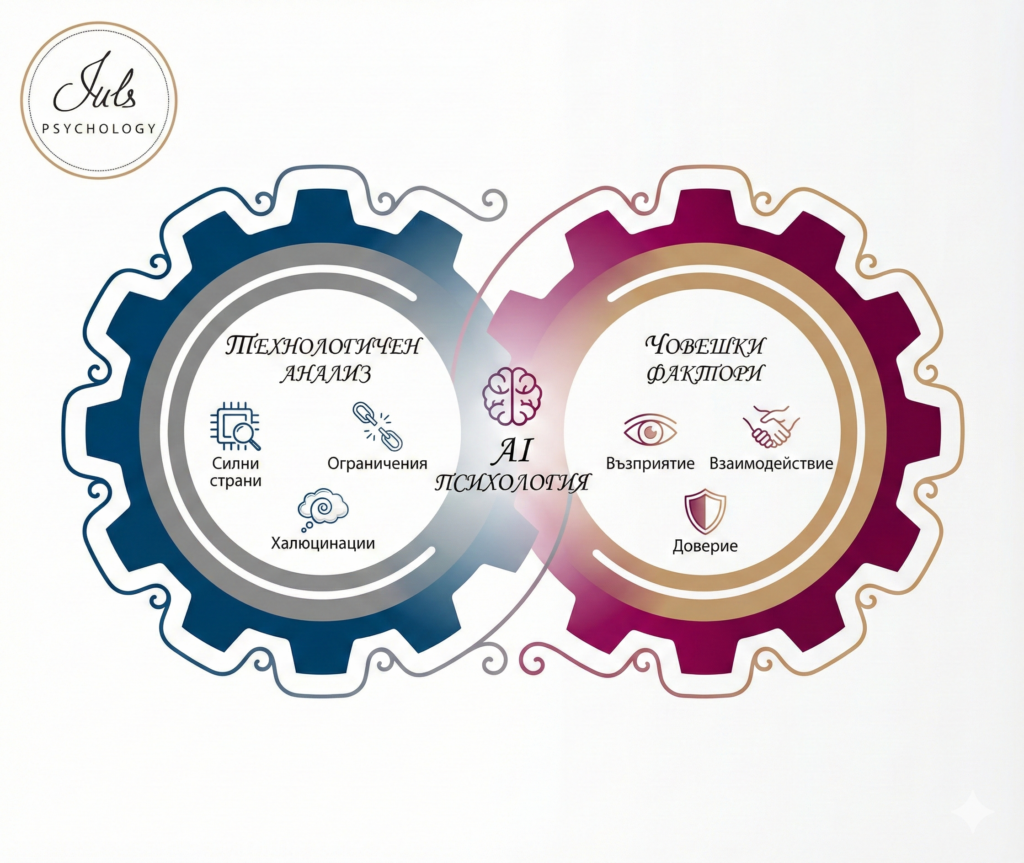

AI Психологията е динамично развиваща се научна дисциплина, която изследва отношенията човек-машина в ерата на дигиталната трансформация. Това е пресечната точка между поведенческите науки и технологиите и все още имаме повече въпроси, отколкото отговори. За да разберем истинското влияние на изкуствения интелект, ние работим в две посоки:

- Технологичен анализ: Познаване в дълбочина на характеристиките на ИИ – неговите силни страни, ограничения и „халюцинации“. Без да знаем къде той греши, не можем да му имаме доверие, нито да му делегираме свобода на действия и решения от наше име.

- Човешки фактори: Изследване как човекът възприема, взаимодейства и се адаптира към ИИ. Човекът има навика да прехвърля отговорност на машините, но ИИ поставя на изпитание това, защото всички вече знаем, че не можем да се предоверяваме на ИИ.

Приложение на AI Психологията: Основната ни задача е да анализираме ползите и рисковете при употребата на ИИ в критични за човека области, за които все още търсим широко приложими отговори:

- Бизнес и работа: Как ще се променят работните процеси, лидерството, културата и екипните динамики?

- Личностно развитие: Как се изменят автентичността, когнитивните умения и емоционалната устойчивост?

- Психично здраве: Какво е влиянието на технологиите върху емоционалния ни свят и какви са рисковете?

- Обучение: Какви нови методи за усвояване на знания можем да развиваме по безопасен начин?

Всеки ден се сблъсквам с последиците от нерегулирана употреба на ИИ, заради което отношенията, доверието и прецизността биват поставени на заден план, за сметка на скоростта и обема, с които днес можем да работим, общуваме и произвеждаме решения и готови отговори.

Този наръчник цели да ви помогне да осмислите една важна истина: ИИ може да ви помогнете да мислите и да отговаряте по-бързо и с по-голям обем на различни заявки, от най-разнообразно естество. ИИ обаче НЕ може да поема отговорност, да но съчувства или да решава кое наистина има значение, нито в личен, нито в професионален план.

Моралът, емпатията и отговорността съществуват, защото ни има нас.

Променяйте. Адаптирайте. Еволюирайте.

Участвай в проучването на Иванка и Александра:

“Как да използваме ИИ прозрачно и етично в работата си”

Целта им е да сглобят общата картина – как фрийлансърите, собствениците на микро- и малък бизнес и служителите в България използват в работата си изкуствен интелект, могат ли, и как, да поставят граници между изискванията на клиентите и натиска на средата и етичната му употреба.

Къде се къса веригата и кои са най-големите рискове при употреба на ИИ?

Къде се къса веригата и кои са най-големите рискове при употреба на ИИ?Работата на ИИ е да “вижда” отвъд нашите умения и да обработва огромни масиви от данни по-бързо от нас. Забележете, не казвам “по-точно”, а само повече и по-бързо и тук се крият редицата проблеми, които вече виждам в работния ден, процесите и задачите на лидери и екипи.

Когато ИИ се внедри в „счупена“ бизнес логика, той не я поправя само и само, защото прави нещата по-бързо от нас. ИИ ускорява разпространението на хаоса във всички посоки, а процесите се усещат от хората като нелогични непоследователни. Това засяга едновременно всичко по веригата: и от клиенти, и от потребители, и от служители. Ето основните пробойни, които изследвам ежедневно:

1. Илюзията за истина и „Черната кутия“

Свикнали сме да вярваме на своите технологии, че когато изчисляват вместо нас, техните резултати са почти винаги точни и верни, т.е. те носят в нас истина. ИИ обаче НЕ е такъв тип машина: изглежда, че притежава памет и известна “свобода да решава”. Но той не “решава” сам какво да каже, а изчислява коя е най-вероятната следваща дума на база на данните, на които е трениран. Затова е по-правилно да се каже, че ИИ е вероятностен, а не детерминистичен (като калкулатора) подход за решаване на задачи, заради което ние няма как да знаем дали даден резултат е точен и верен.

И ето тук се раждат масовите проблеми при работа с ИИ: можем ли да гледаме на ИИ анализите/задачите като на “истина” или само като на “полу-истина”? Какво поражда този парадокс?

Сценарии вместо проблеми:

И разпознава как говорим за проблемите си, а не самите проблеми. Той измисля връзки там, където такива не съществуват. С други думи, той анализира патерните от проблемите така, както ние ги подадем. Може да доразвие анализа в разни посоки, но това ще са догадки, а не истинни данни.

Вероятност vs. Абсолютност:

Резултатите на ИИ са с вероятностен характер, но хората ги възприемат като абсолютна истина (1 или 0), просто защото са генерирани от машина.

Сканиране на хаоса:

ИИ оперира на принципа на черната кутия – той не може да обясни как е стигнал до дадена идея, което прави проследяването на логическата грешка почти невъзможно.

2. Замърсяване на данните и загуба на персонализация

Можем да кажем на ИИ как хората мислят и говорят за проблемите си (за храним го с тренинг данни). Когато после отново говорим по същата тема, той ще се опитва да отгатне какво го питаме. После ще потърси на това питане как най-често хората са отговаряли преди и ще ни го предложи като решение. На нас ни се струва, че е креативно и иновативно, че решава проблема, но не си даваме сметка за няколко дълбоки аспекта:

Информационен дефицит:

Огромна част от данните, с които захранваме системите, вече са „замърсени“ от самия ИИ. Светът изпитва недостиг на чисти данни, създадени изцяло от хора. С други думи, ИИ казва на ИИ какво казват хората, а после хората действат като оператори, защото вярват, че това е така. Какво става обаче, ако данните изначално са плод на халюцинации?

Шаблонизация на доверието:

Моделите постигат 80% ефективност чрез шаблони, но липсата на персонализация в ключовите 20% чупи човешкото доверие. Не можеш да решаваш един и същи проблем в 100% от ситуациите по един и същи начин, дори и хората да използват едни и същи думи за това. И го виждам всеки ден – какъв е смисълът да произвеждаш съдържание за уеб, ако не предлагаш нищо ново, друго и различно, ако не говориш различно и ако не внасяш новост в света на потребителите и нишата си?

Шаблоните ни трябват, но те са около 40% от гръбнака на всяка услуга, оферта, кампания, имейл или пост. Останалите 60% следва да носят усещане за новост (поне 10%), дълбочина (30%), приложимост (20%). С други думи, един шаблон работи за бизнес системата само ако решава фокусно проблем по ясен и структуриран начин, за който дори неопитен човек ще вижда смисъл и ще може обективни да види новаторството ти.

3. Капанът на ефикасността

Тази тема е толкова огромна, че ще я разгледам в отделна статия по-натам, а днес само ще маркирам двата основни проблема с ИИ:

Разходът „Одит“:

Проблемът с „90-те процента ефикасност“, които често вървят ръка за ръка с офертите за автоматизации през ИИ е, че останалите 10% грешки са толкова фино вплетени, че изискват по-висока квалификация за откриване, отколкото самото изпълнение на задачата. Това не е спестяване на време, а прехвърляне на разхода от „правене“ към „одитиране“.

Тук човешкото съзнание започва да работи значително по-бавно, защото ние сме по природа отркиватели и завояватели, а не надзиратели и редактори. Ние обичаме да създаваме реалност, а не да я коригираме под лупа 24/7. Ако не ми вярвате, поговорете си с програмисти, UX, специалисти, редактори, дизайнери и прочие професии: те ще ви кажат, че е по-лесно да се гради наново, когато логиката е счупена, отколкото да се редактира и кърпи на парче.

Загуба на бранд-гласа през личното „Защо“:

Когато бизнес процесите се делегират изцяло на ИИ, бизнесът губи своята същност – заради стереотипите в езика на изразяване. Ако технологията изчезне утре, микро бизнесът ще остане с кухи системи, които никой не знае как да управлява ръчно – толкова процеси се делегираха на ИИ през 2025 и ако трябва да сме честни, повечето се задоволяват с ниска персонализация, стига да има обем и скорост.

За мен това е илюзия за движение, а не прогрес и се радвам, че брандовете, с които продължавам да работя, за фокусирани върху лично отношение, индивидуалност, имидж и престиж, за това гради доверие, спокойствие и устойчиви отношения. За микро бизнесите и солопредприемачите автентичните емоции и креативните споделяния са солта на отношенията. Преди да прехвърлите всички публични комуникации на ИИ, замислете се за чувствата на потребителите си.

Брандът НЕ е това, което казваш и правиш, а как хората се чувстват, докато те слушат.

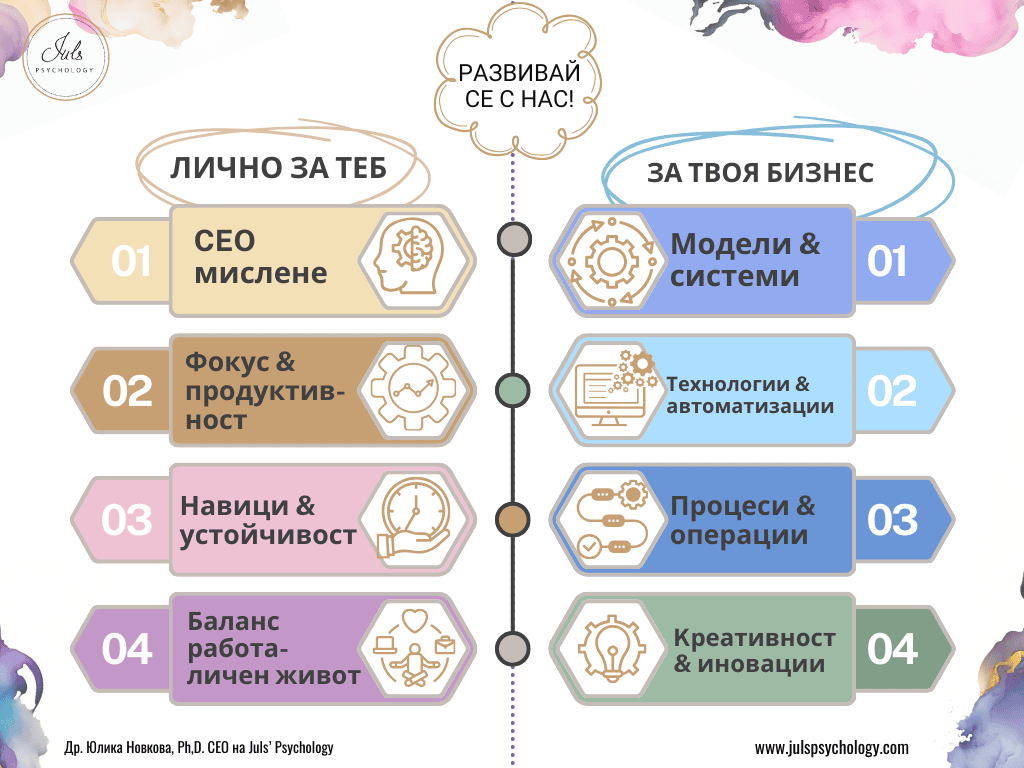

Бизнес психологията, личността и върховото представяне с ИИ

Дисциплинирай ума си и се научи да фокусираш усилията си така, че да намираш точните решения без да прегаряш. Запази си сесия с мен и работи за остър ум, спокойни емоции и активни действия. ИИ трябва да те следва, а не да те превръща в механичен оператор, който гаси безсмислени пожари.

Психологическата цена на „липсата на триене“

Един от най-невидимите, но опасни аспекти на ИИ, е премахването на здравословното съпротивление (конфликти, несъответствия, спорове). Без това „триене“ идеите не се каляват – те стават меки и шаблонни.

Могат да ти донесат моментно емоционално облекчение, могат да донесат инсайти и нови ъглъ за нещата, които вече знаеш, но и това идва с цена, за която ще разкажа в отделна тема, защото е важно да знаеш дали ИИ може да бъде твой личен партньор за личностно и бизнес развитие.

Ето с какво най-често се сблъсквам при работата с клиенти, които прекомерно разчита на ИИ през деня си и как взаимодействието с него води до сериозни и реални поведенчески промени:

Атрофия на мисленето:

Става все по-трудно да мислим самостоятелно, да вземаме категорични решения и да поемаме лична отговорност за риска. Хората се съмняват да изпратят информацията, тревожат се от грешки, но и не знаят как да проверят всичко, а и най-често нямат време.

Все по-трудно се концентрираме и фокусираме, все по-разсеяни и изтощени сме, защото ИИ има още една страна: заради обема и скоростта си изобличава човека като бавен, муден и направо “ненужен” в работния ден. Човекът просто НЕ може да обработва толкова данни, да верифицира толкова резултати и да анализира и валидира критично толкова информация. Особено сложно е, когато ние НЕ знаем логиката или пътя, по който е взето дадено решение.

Социална непоносимост:

Ставаме раздразнителни при липса на незабавно валидиране и емпатия в общуването си с околните. Трудно понасяме несъгласията и конфликтите с реални хора, искаме те да не се обясняват и да отговарят като ИИ – ясно, точно, кратко. Механичните отношения нараняват партньорските ни отношения, защото в една връзка единният е винаги една идея по-разговорлив, цветен, емоционално оценъчен, а за преуморените умове подобна интеракция се усеща като безсмислен разход на липсваща енергия. Толкова е осакатяващо, не мислите ли>

ИИ като личен партньор/компаньон:

Ставаме по-груби в личните си отношения и все по-често търсим компанията на ИИ за личен приятел/компаньон, вместо да инвестираме в човешки връзки. ИИ не ни прекъсва, съгласява се, заучен е на емпаия, уверява те в правотата на гледната ти точка и затвърждава позициите ти в собствения ти ум.

После, когато се обърнеш към другия, неговия емоционален хаос, несвързана логика и липсващо разбиране за теб и гледната ти точка, ни кара да сме груби, избухливи и гневливи. Знам, че гневът ни нараства, защото това е втората най-четена статия в моя сайт за последните 8 г. и аз непрекъснато я обновявам – “Как да се справим с гнева си?”

Регулаторната рамка на Европейския Съюз за 2026: Краят на „Дивия запад“ за ИИ инструментите

За да разберем защо сигурността и валидността на процесите вече не са просто пожелателни, трябва да погледнем към правната карта на Европа. По данни, публикувани от Grünecker в Lexology на 14 януари 2026 г., текущата година е повратна точка, в която регулациите преминават от теория в реални задължения с тежки финансови последствия.

Ето какво предстои в Европа и как то директно засяга микро бизнеса и създателите на ИИ решения:

1. AI Act: Регулация на високорисковите системи (от 2 август 2026 г.)

Повечето разпоредби на Европейския регламент за ИИ (AI Act) влизат в сила в началото на август 2026 г. Това е моментът, в който „черната кутия“ на ИИ трябва да стане прозрачна. Ако вашият бизнес модел разчита на ИИ за вземане на решения, които засягат здравето, безопасността или основните права (високорисков сегмент), вече не можете да се оправдавате с „машината така реши“. Доставчиците трябва да започнат привеждане в съответствие сега, за да избегнат блокиране на услугите си.

Какво значи това за бизнеса?

На практика това означава, че всяко решение, което излиза от нас, следва да бъде верифицирано от човешки експерт с нужните знания, умения и акредитации, които го доказват. Може и да искаш да създадеш инструмент, който да продаваш и да замества високо регулирани професии, но можеш ли да защитиш и обосновеш логиката и решенията, които инструментът ти продава?

2. Cyber Resilience Act (CRA): Отговорност за „Wrappers“ (юни и септември 2026 г.)

Това е може би най-критичната регулация за микро бизнесите, които продават т.нар. Wrappers (AI + API + Local Training). CRA въвежда задължителни изисквания за киберсигурност за всички продукти с цифрови елементи. * От средата на 2026 г. производителите са длъжни активно да докладват за експлоатирани уязвимости и инциденти със сигурността.

Какво значи това за бизнеса?

Вече не е възможно рискът да се прехвърля изцяло на крайния клиент. Липсата на протоколи за разпределение на отговорността ще се счита за пряко нарушение. С CRA, Европейският съюз казва на бизнеса: “Ако печелите от софтуер, трябва да носите отговорност за неговата безопасност, точно както ако продавахте детски играчки или електроуреди.” Рискът от хакерска атака или изтичане на данни вече не е проблем на потребителя (“да е внимавал”), а директна правна и финансова отговорност на създателя на обвивката.

3. Data Act: Достъп до данните и прозрачност (от 12 септември 2026 г.)

Регламентът за данните на ЕС въвежда правила за достъп и използване на данни, генерирани от свързани продукти. Производителите трябва да гарантират, че данните са директно достъпни за потребителите. В Германия, например, вече се предвиждат глоби до 4% от годишния оборот за нарушения. Това директно адресира проблема със „замърсените данни“ – бизнесът ще трябва да доказва произхода и чистотата на информацията, с която борави.

Какво значи това за бизнеса?

Трябва да има собствена, предварително дефинирана логика и процеси, за да можеш пи грешни резултати да обърнеш максимално точно процеса и да проследиш кога, какво, защо и как се е объркало и да го поправиш.

4. NIS 2: Разширен обхват на сигурността

Директивата NIS 2 значително разширява кръга от субекти, които трябва да поддържат високи стандарти за информационна сигурност. Ако вашият микро бизнес е част от веригата на доставки на по-голяма компания, вие ставате част от този регулиран периметър – изисквайте данни, информация и процеси и се стремете да носите ограничена отговорност за нещата, които минават през вас, както и да се освобождавате от такава, ако другите по веригата НЕ са толкова старателни и отговорни като вас.

Източник: Peters, M., & Rützel, F. (2026, January 14). IT Law in 2026: What Businesses Need to Prepare For. Grünecker / Lexology.

Защо тези регулации адресират реални рискове в бизнес логиката?

Тези законодателни промени не са просто административни пречки и бизнесите на запад вече реагират. Те са директен отговор на хаоса, който върви ръка за ръка с характера на ИИ, който описвам днес за вас:

Рискът „Черна кутия“:

Регулациите изискват обяснимост. Ако ИИ скалира хаос, който не можете да проследите, вие вече сте в нарушение на изискванията за прозрачност. Ако делегирате огромни задължения на ИИ във всеки аспект на работата си, ако ИИ агентите са вашата лична система за продуктивност, то рисковете за вашите крайни потребители в момента са огромни, а след няколко месеца те ще могат да ви подвеждат и под лична отговорност.

Вероятност vs. Валидност:

Когато законът изисква „надеждност“, вероятностният характер на ИИ резултатите се превръща в юридически риск. „Може би това е вярно“ не е валидна защита в съда. Дори като консултанти да предлагате решения, базирани на ИИ, те следва да са огледало на вашите вече налични знания, експертизи и умения, а НЕ търговски трик и липса на адекватни професионални умения, които да предлагат валидни решения. Всеки консултант носи ограничена отговорност за препоръките си, но ако тези препоръки са зловредни и вие не сте ги проверили ръчно, т.е. не притежавате експертизата да оцените дали продавате относително валидно решение или просто ИИ генерира вероятностен шум, отговорността ще е ваша и скоро ще бъде наказателна такава.

Изчезването на „Защо“ в отношенията човек-бизнес:

Бизнесите с кухи системи няма да преминат одитите за съответствие, защото няма да могат да обяснят логическия път на своите процеси. А логиката върви ръка за ръка с експертизата, а тя идва с образование, дипломи, лицензии и сертификации. Процесът следва да е ясно описан и деклариран, а ИИ следва да минава през него.

Как ползваме при нас ИИ за вътрешни цели при изграждане на процеси?

Моят бизнес е типичен пример защо ИИ не може да бъде фундамент на процеси, кога е ускорител и кога замърсява клиентските казуси и ще ви го демонстрирам в различни аспекти: като вътрешен, оперативен процес и като част от услугите за моите клиенти. Моят бранд изглежда технологично консервативен и умерено автоматизиран и затова премина успешно одитите за киберсигурност и защита на потребителите и личните данни.

Всички нови клиенти минават през стандартизиран процес, където комуникацията е персонализирана, структурирана, регулирана и частично автоматизирана:

човек -> машина -> човек

1. Новите клиенти попълват въпросник, в който споделят теми, проблеми, цели, очаквания, създаден лично от мен на база 15 години опит като бизнес психолог и екзекютив консултант;

2. Данните на клиента се агрегират и се заличава личната информация ПРЕДИ да използваме ИИ. С помощ на ИИ правим количествено-качествен анализ на данните, за да не пропуснем теми, въпроси и ценности, както и за да помогнем на клиента да оформи в главата си плана за срещата. Данните пристигат при нас емоционални, хаотични и неструктурирани и ние помагаме още тук да се въведе малко ред, но следваме ритъма на клиента: така, както той го е задал още във въпросника и последващите имейли, запитвания през социалните мрежи и коментари под статии.

3. Прави се одит на анализа от експерт и се оформя доклад към клиента. Ние не обучаваме ИИ с вашите данни (Zero-training policy). Този доклад се връща към клиента с персонализиран имейл, съставен от човек, с питане дали правилно сме уловили и структурирали информацията и дали това ще са най-спешните теми за решаване. Понякога клиентите променят фокуса си в движение, но се чувстват разбрани, подкрепени и оценени и знаят, че те решават как да управляват времето и парите си.

4. По време на срещите НЕ ползваме ИИ и НЕ записваме разговорите, за да запазим най-високо ниво на конфиденциалност. Всички записки се водят лично от мен в реално време в споделен Гугъл документ, без намесата на транскрибиращи ботове. Така гарантираме, че няма скрит запис на вашите думи. След срещата клиентите получават пълен достъп до документацията си.

5. Всички клиентски данни се съхраняват само на сървърите на Гугъл, където сме разположили целия ни виртуален офис : от въпросника за Първоначалната консултация и споделените документи, до имейлите. Нищо не се прехвърля на локални сървъри, клиентите имат 24/7 достъп до цялата си документация, процес, стратегии и ноу-хау. Единственият външен софтуер е календара, Calendly, но там клиентът има пълен контрол над данните които въвежда и ние нямаме достъп до тях.

6. Във вътрешно-оперативен план ИИ се ползва със следните конкретни цели и във връзка с конкретни стъпки от оперативния процес (никога за цели процеси и не без човешки надзор):

– Изследователски цели – събираме бързо данни и правим контролирани проучвания, както и извършваме статистически анализи. Всички източници обаче се проверяват ръчно.

– За структуриране на проблеми през системни анализи: така не пропускаме нищо важно и поддържаме общата картина на нещата. Договорните отношения обаче се управляват от хора, за да няма юридически халюцинации.

– За превод на съдържание на друг език, езикови редакции и смислови несъответствия – аз съм с дислексия и за мен напрежението да създавам писмено съдържание спадна много, защото сега имам доверен помощник, но всички текстове минават през една рамка-задача: “ИИ, полирай текста, НЕ променяй, изтривай или добавяй съдържание. Ако има критични забележки ги изведи като отделен списък по реда на поява в текста. Аргументирай се”.

– За генериране на персонализирани визии и онагледяване на сложни конструкти под формата на схеми (като настоящите в тази публикация).

– За трансформация на съдържание в различни формати, дължини и форми, но при стриктни политики, ограничения и изисквания за брандиране, за да може във всеки канал да виждате винаги Juls’ Psychology.

Изкуственият интелект е технология, а не решение

Ако не помогнеш на човек да усвои и съхрани при себе си твоето ноу-хау, то ти създаваш алгоритъм на зависимост: клиентът има нужда всеки път от теб, за да си реши сходен проблем. Това може и да ти носи спокойствие (временно) за регулярни доходи, но създава вътрешно напрежение у клиента – той/тя трябва да те търси за всяка малка подробност и това блокира операциите.

Бизнесът не се скалира с „може би“ – той изисква предсказуемост и устойчивост на процеса. Ако предефинираната логика на ИИ чупи вашата собствена Бизнес ПсихоЛогика, ИИ-генерираният резултат ще изглежда логичен, но ще бъде неприложим, недостоверен или подвеждащ.

Моята работа не е просто да „строя“ с ИИ, а да ровя под камъните – там, където се къса връзката между човека, задачата, психологията и процеса. Защото истинската устойчивост идва не от скоростта на алгоритъма, а от яснотата на човешкия разум зад него.

Как се постига точност на резултатите с ИИ над 98%?

Краткият отговор е: Не чрез магия, а чрез архитектура на процеса и отговорен контрол.

За да преминете границата от 80% (стандартното “добро” ниво на ИИ) към 98%+ (професионално ниво), трябва да спрете да третирате ИИ като “оракул” и да започнете да го ползвате като “процесор”.

Ето формулата, която работи за повишаване на надеждността и валидността на данните от ИИ:

- Ограничаване на контекста (RAG): Не питайте ИИ “какво знае по света”. Захранете го с вашите конкретни документи, правила и данни и му забранете да ползва външна информация. Когато ограничиш периметъра на знанието само до “истината”, която ти си му подал, халюцинациите изчезват. Тези данни следват да се изготвят от човек и да са добре формулирани и като правила, и като процеси, и като посоки. Това отнема време енергия, фокус и прецизност.

- Верига на мисълта (Chain of Thought): Не искайте ИИ да ви предостави крайния отговор веднага след като въведете заявката си. Накарайте модела първо да изведе логиката, да опише стъпките и чак тогава да даде заключение. Когато “виждате” как мисли машината, лесно хващате къде се къса логиката – и тук стават много грешки, но е по-лесно да обърнете процеса, особено ако вие самите сте предефинирали фундамента на тази логика.

- Човекът като валидатор (Human-in-the-Loop): Останалите 2% до 100% са вашата експертиза. ИИ върши “черната работа” по обработката, но експертът слага подписа – сега е въпрос на лична етика и отговорност, но скоро ще придобие тежестта на европейска регулация. Бъдете отговорни каки решения и препоръки ускорявате с ИИ и се грижете за здравето, благополучието и просперитета на клиентите си, а не само за краткосрочната си доходност.

Както виждате, подобна точност от 98% няма как да се постигне, ако разчитате на стандартните генерализирани LLM (ChatGPT, Gemini, Grok) или на базови „wrapper“ решения (API + Prompt Engineering). Нито едно от тези условия за сигурност и контекст НЕ може да бъде изпълнено категорично в такава среда на висока несигурност и неяснота.

Остават и проблемите със „замърсените“ данни, с които непрекъснато трябва да захранвате алгоритъма, както и огромният етичен казус: дали да тренираме модели с чувствителните казуси на своите клиенти.Точността при работата с ИИ не е функция на самия софтуер, а на вашата лична способност да задавате ясни критерии и да управлявате процеса и личната отговорност в процеса.

Регулациите не чакат. Психиката на екипа ти – също. Спри да делегираш мисленето на машините и поеми отговорност за процесите си. Запази час за одит на твоята бизнес логика и създай среда на психологическа безопасност и доверие.

Не консумирай чужда реалност, създай си своя собствена

Знам, че понякога е твърде трудно да продължим и че губим смисъл и желание да творим и създаваме. Вярвам, че заедно ще намерим как да минеш и през този сложен етап в личен или бизнес план. Защото вярвам в теб и в смисъла от твоя труд, мисли и идеи.

#ТиИмашЗначение, сподели историята си:

Клиентите на Juls’ Psychology споделят:

Споделени истории за хора и пътища:

ВРЪЗКИ С ОБЩЕСТВЕНОСТТА: Медийни изяви и Стратегически партньори

Най-важният ресурс за своя успех си ТИ!